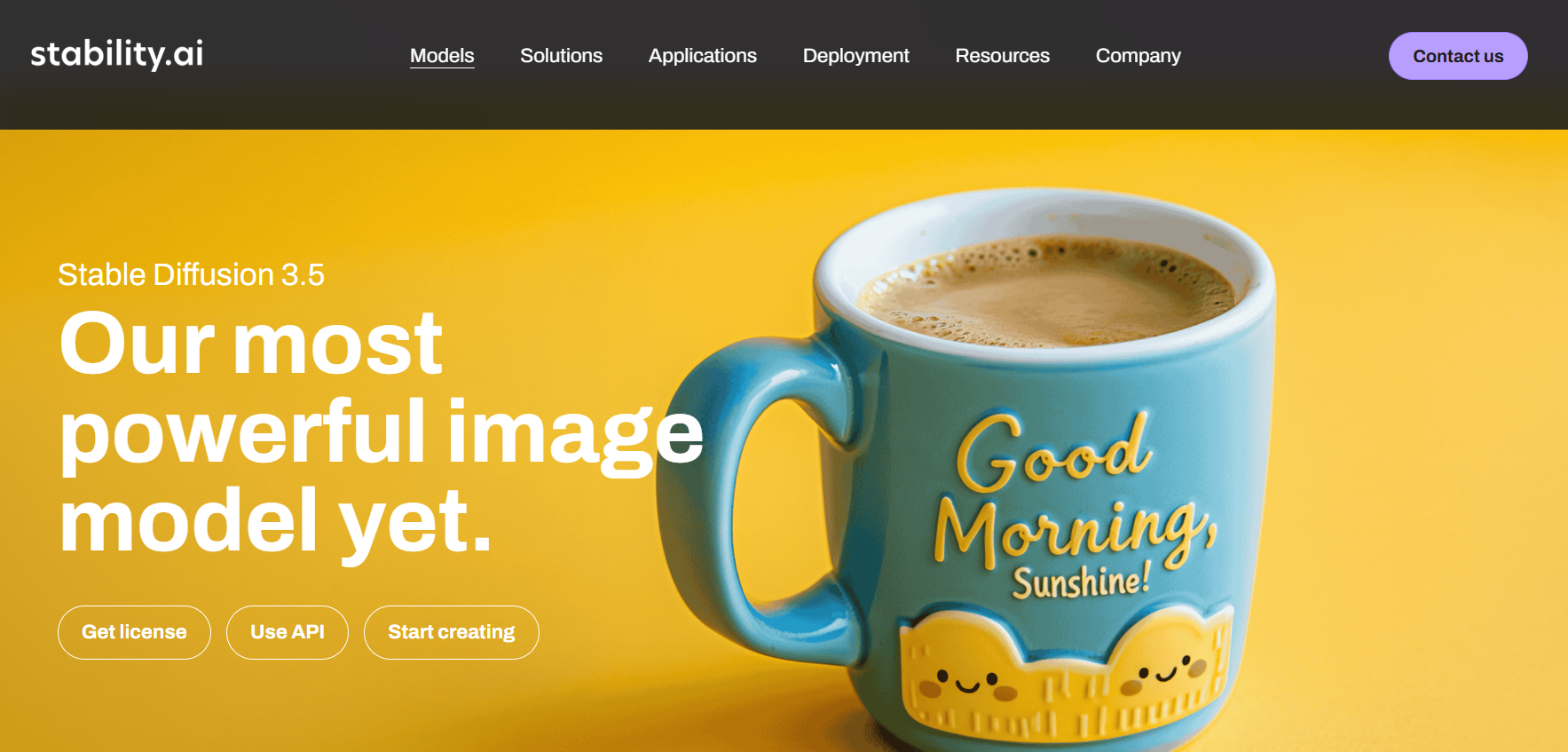

Stable Diffusion : solution d’IA générative pour une souveraineté graphique

Générer des milliers d’images sans abonnement, sans filtre imposé et sans que vos données ne transitent par un serveur tiers : c’est la promesse de Stable Diffusion. Là où Midjourney ou DALL-E vous placent dans une dépendance à une plateforme propriétaire, Stable Diffusion propose une autre voie — celle du modèle open-weight, installable localement, modifiable librement et exploitable sans frais marginaux. Développé par Stability AI depuis 2022, il est aujourd’hui le standard de référence pour les professionnels exigeant un contrôle total sur leur production visuelle IA.

Découvrir Stable Diffusion

Stable Diffusion n’est pas un outil au sens classique du terme : c’est un modèle de génération d’images que vous pouvez déployer de plusieurs façons selon votre niveau technique et vos besoins.

La voie la plus accessible est d’utiliser une interface web comme Automatic1111 WebUI ou ComfyUI, deux applications gratuites qui s’installent sur votre machine et offrent une interface graphique complète. ComfyUI s’est imposé comme la référence en 2025-2026 grâce à son système de workflow visuel par nœuds, qui permet de construire des pipelines de génération complexes sans écrire une ligne de code. Pour les profils moins techniques, des services SaaS comme DreamStudio (le service officiel de Stability AI) offrent un accès direct depuis le navigateur, moyennant des crédits à l’achat.

La technologie repose sur une architecture de diffusion latente (LDM) : le modèle travaille dans un espace mathématique compressé pour réduire la charge de calcul, puis reconstitue l’image finale. À partir de la version SD 3.5, Stability AI a adopté une architecture Diffusion Transformer (MMDiT-X), plus proche des approches utilisées par les grands modèles de langage, qui améliore significativement la compréhension des prompts complexes et le rendu du texte dans les images.

L’exécution locale nécessite un GPU compatible. Sur une carte NVIDIA RTX 4090, une image en 1024×1024 se génère en 2 à 3 secondes. Sur un GPU milieu de gamme (RTX 3060, 12 Go VRAM), comptez 8 à 12 secondes. Les puces Apple Silicon sont également supportées via l’accélération Metal.

Les modèles disponibles en 2026

Stable Diffusion existe en plusieurs versions, chacune adaptée à des besoins différents.

Stable Diffusion 3.5 (sorti en octobre 2024) est la version la plus avancée à ce jour. Elle se décline en trois variantes : SD 3.5 Large (8 milliards de paramètres, qualité maximale), SD 3.5 Large Turbo (8B paramètres, génération accélérée en moins d’étapes) et SD 3.5 Medium (2,6 milliards de paramètres, adapté aux configurations grand public). SD 3.5 corrige les lacunes de SD 3 Medium — dont Stability AI avait elle-même reconnu publiquement qu’il ne répondait pas aux attentes de la communauté — en améliorant le réalisme, la fidélité aux prompts et la gestion du texte dans les images.

SDXL reste très utilisé dans la communauté pour sa compatibilité avec un vaste écosystème de modèles personnalisés disponibles sur la plateforme Civitai : RealVisXL pour le photoréalisme, Juggernaut XL pour un usage polyvalent, DreamShaper XL pour le concept art et le fantastique, Animagine XL 4.0 pour l’illustration anime.

Les modèles se téléchargent gratuitement depuis Hugging Face ou Civitai au format .safetensors et s’installent en les déposant dans le dossier dédié de l’interface choisie.

Fonctionnalités clés

Contrôle fin de la génération

Stable Diffusion expose des paramètres absents de toute solution SaaS concurrente. Vous choisissez parmi plus de vingt algorithmes d’échantillonnage (samplers) — DPM++ 2M Karras pour une convergence rapide en 20 étapes, Euler a pour les itérations rapides. Le CFG Scale (Classifier-Free Guidance) règle la fidélité au prompt : entre 5 et 7 pour une liberté créative, au-delà de 12 pour coller strictement aux instructions. Chaque paramètre influe sur la texture, la netteté des bords et la cohérence stylistique du résultat.

LoRA : injecter un style en 150 Mo

Les fichiers LoRA (Low-Rank Adaptation) sont de micro-modèles de 50 à 200 Mo permettant d’injecter un style précis, une charte graphique ou un visage spécifique sans réentraîner le modèle complet. Des milliers de LoRA sont disponibles gratuitement sur Civitai, couvrant des univers aussi variés que la photographie argentique, l’illustration éditoriale ou l’identité visuelle de marques fictives.

ControlNet : contrôler la structure spatiale

ControlNet est une extension qui permet d’imposer une contrainte structurelle à la génération. En mode Canny, vous fournissez une image de contours et l’IA reconstitue l’image en respectant exactement ces contours. En mode Pose, vous imposez la posture d’un personnage. En mode Depth, vous contrôlez la profondeur de champ. C’est l’outil indispensable pour la production en série (packshots e-commerce, illustrations éditoriales cohérentes, storyboards).

Inpainting et Outpainting

Le mode Inpainting permet de modifier une zone précise d’une image existante sans altérer le reste — corriger un visage, changer un arrière-plan, supprimer un objet. L’Outpainting étend l’image au-delà de ses bordures originales. Ces deux modes sont particulièrement utiles pour les retouches de production sans avoir à tout régénérer.

API REST et intégration

Stable Diffusion expose une API REST permettant d’intégrer la génération directement dans vos propres outils, workflows ou applications. C’est ce qui le rend incontournable pour les équipes techniques souhaitant automatiser la production visuelle.

Cas d’usage professionnels

E-commerce et catalogue produit : en combinant ControlNet (pour conserver la forme exacte du produit) et la génération de fond, vous créez des packshots avec différents arrière-plans et éclairages à la chaîne. Les coûts de photographie sur catalogue peuvent être réduits de façon significative pour les références répétitives.

Concept art et développement de jeux : générer des variantes visuelles rapidement pour valider des directions artistiques, créer des textures tileables, corriger des zones de décors via l’inpainting. Les studios indépendants utilisent Stable Diffusion pour la phase de pré-production là où une équipe d’artistes aurait été nécessaire.

Architecture et visualisation : transformer un croquis filaire ou un plan 2D en rendu photoréaliste avec différentes ambiances lumineuses et matériaux. Utile pour les présentations clients rapides avant l’engagement dans des rendus 3D complets.

Veille concurrentielle et synthèse visuelle : les équipes marketing utilisent l’outil pour produire des illustrations de rapports, de présentations ou de contenus éditoriaux en interne sans dépendance à des banques d’images payantes.

Tarifs

C’est le point de différenciation absolu de Stable Diffusion : les modèles sont gratuits et la génération en local n’engendre aucun coût marginal. Vous payez une fois votre matériel, et vous générez autant d’images que vous le souhaitez.

Les seuls coûts éventuels sont les suivants : si vous optez pour une interface SaaS comme DreamStudio (Stability AI), vous achetez des crédits à l’usage — comptez quelques centimes par image en haute qualité. Si vous déployez sur cloud GPU (RunPod, Vast.ai, Google Colab), vous payez le temps de GPU loué, généralement entre 0,20 $ et 0,50 $ de l’heure pour un GPU de milieu de gamme.

La licence Stability AI Community License permet un usage gratuit, y compris commercial, sous réserve que votre revenu annuel ne dépasse pas 1 million de dollars. Au-delà, une licence commerciale spécifique est à négocier avec Stability AI.

Points forts et limites

Points forts

- Gratuité totale en local, sans abonnement ni coût marginal à l’image.

- Confidentialité absolue : aucune donnée ne quitte votre réseau en mode local, idéal pour les contenus sensibles ou propriétaires.

- Écosystème communautaire : plus de 100 000 modèles, LoRA et extensions disponibles sur Civitai et Hugging Face.

- Contrôle granulaire sans équivalent : chaque paramètre de génération est accessible et ajustable.

- Pas de censure imposée : contrairement aux outils SaaS qui filtrent certains contenus, la version locale n’applique aucune restriction éditoriale externe.

- Intégration technique : API REST, compatibilité avec les outils de production professionnels.

Limites

- Barrière technique réelle : l’installation et la configuration d’Automatic1111 ou ComfyUI demandent un minimum de culture technique (Python, gestion des dépendances). Les mises à jour fréquentes des librairies peuvent casser l’environnement installé.

- Matériel requis : un GPU avec au minimum 8 Go de VRAM est recommandé pour un usage confortable. Les utilisateurs sans GPU dédié seront contraints aux solutions cloud ou SaaS.

- Anatomie complexe : les modèles de base restent imparfaits sur le rendu des mains et des doigts — un point d’amélioration en cours mais pas encore entièrement résolu même dans SD 3.5.

- Enjeux juridiques en cours : des procédures judiciaires concernant les données d’entraînement (dataset LAION) sont toujours en cours dans plusieurs pays. La situation légale sur le droit d’auteur des images générées reste à surveiller selon votre usage.

- Pas d’interface unifiée officielle : contrairement à Midjourney ou DALL-E, il n’existe pas d’interface « prête à l’emploi » officielle. L’expérience varie selon l’interface choisie.

Notre recommandation

Stable Diffusion s’adresse avant tout aux profils pour qui la maîtrise technique est une valeur en soi : designers, développeurs, équipes créatives en agence ou en entreprise qui souhaitent intégrer la génération d’images dans leurs workflows de production sans dépendre d’un prestataire externe.

Pour un usage régulier et intensif — catalogue e-commerce, production de contenu visuel à grande échelle, intégration dans un pipeline logiciel — le rapport coût-performance est sans équivalent sur le marché. Aucun abonnement SaaS ne peut rivaliser sur le volume et le contrôle offerts.

Pour les profils moins techniques ou les usages ponctuels, des alternatives comme Midjourney (qualité esthétique immédiate, sans configuration) ou Adobe Firefly (intégration dans la suite Creative Cloud, cadre légal clair sur les droits) peuvent être plus adaptées.

Si vous souhaitez tester sans installation, commencez par DreamStudio ou un service Google Colab pour vous familiariser avec les paramètres, avant d’envisager un déploiement local sur votre propre machine.

Mise à jour : février 2026